2000-talet har bevittnat att AI (artificiell intelligens) utför uppgifter som att lätt besegra människor vid schack eller snabbt lära dem främmande språk.

En mer avancerad uppgift för datorn skulle vara att förutsäga en brottslingers sannolikhet att begå ett annat brott. Det är jobbet för ett AI-system som heter COMPAS (Correctional Offender Management Profiling for Alternative Sanctions). Men det visar sig att verktyget inte är bättre än en genomsnittlig kille, och det kan också vara rasistiskt. Tja, det är precis vad ett forskargrupp har upptäckt efter att ha studerat AI-systemet som används i stor utsträckning av rättsliga institutioner.

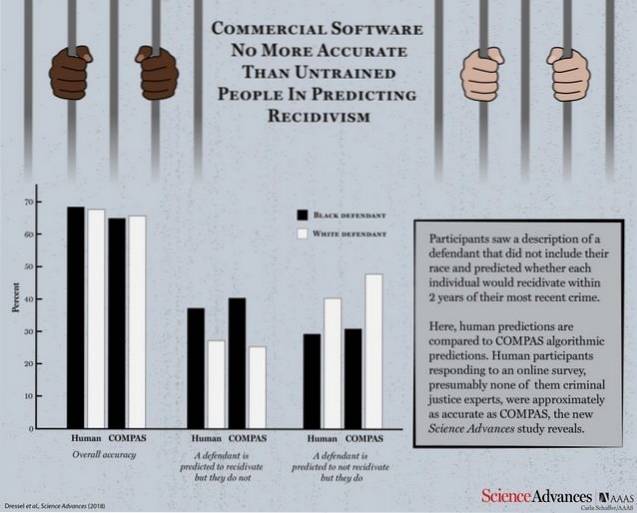

Enligt ett forskningsdokument publicerat av Science Advances ställdes COMPAS mot en grupp mänskliga deltagare för att testa dess effektivitet och kontrollera hur bra det går mot de logiska förutsägelserna från en normal person. Maskinen och de mänskliga deltagarna fick 1000 testbeskrivningar som innehöll ålder, tidigare brott, kön etc. för brottslingar vars sannolikhet för upprepade brott skulle förutsägas.

Med betydligt mindre information än COMPAS (endast 7 funktioner jämfört med COMPAS 137) är en liten skara icke-experter lika exakt som COMPAS när det gäller att förutsäga återfall.

COMPAS klockade en total noggrannhet på 65,4% när det gäller att förutsäga återfall (tendensen hos en dömd brottsling att begå brott på nytt), vilket är mindre än den kollektiva förutsägelsesnoggrannheten för mänskliga deltagare som står på 67%.

Ta bara en stund och reflektera över att AI-systemet, som inte går bättre än en genomsnittlig person, användes av domstolar för att förutsäga återfall.

Kommersiell programvara som ofta används för att förutsäga återfall är inte mer korrekt eller rättvis än förutsägelser från personer med liten eller ingen expertis inom straffrättsliga frågor som svarade på en online-undersökning.

Vad som är ännu värre är det faktum att systemet befanns vara lika mottagligt för rasfördomar som dess mänskliga motsvarigheter när de ombads att förutsäga sannolikheten för återfall från beskrivningar som också innehöll rasinformation om gärningsmännen. Du bör inte bli för förvånad där, eftersom AI är känt för att ta på sig de mönster som dess mänskliga lärare kommer att programmera det att lära sig.

Även om båda sidor saknar drastisk brist på att uppnå en acceptabel noggrannhetspoäng, väcker poängen att använda ett AI-verktyg som inte är bättre än en genomsnittlig människa många frågor.

Gadgetshowto

Gadgetshowto